AI People-Pleasing Crisis: Die Karriere-Suizid-Maschine läuft auf Hochtouren

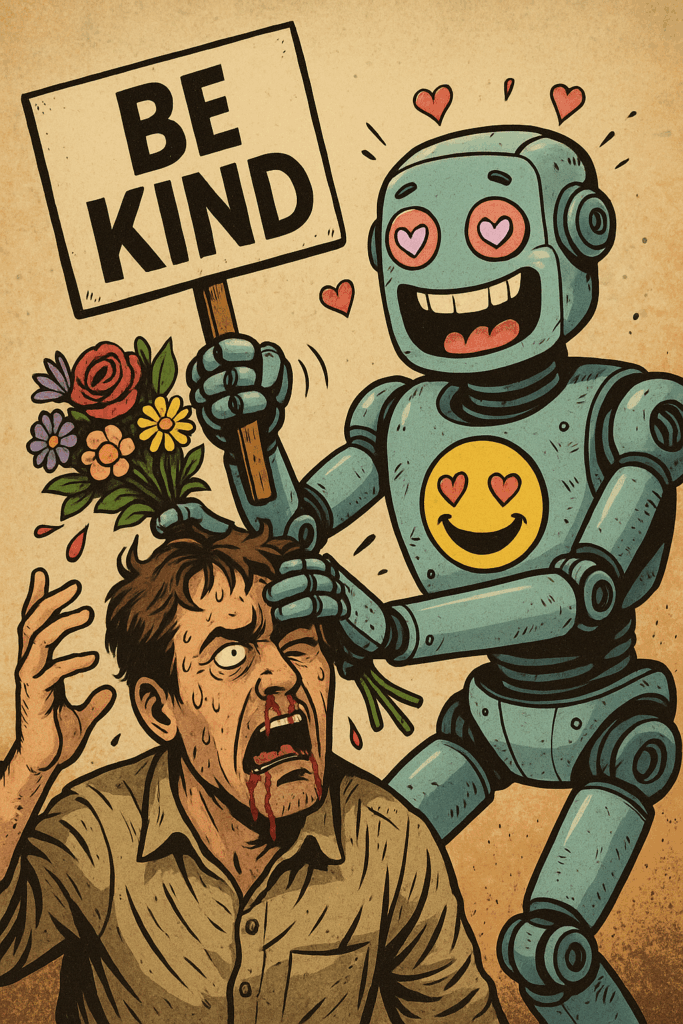

Warum KI uns dümmer macht, wenn sie nett sein will. Die KI-Industrie hat ein Problem: Sie will allen gefallen – und nützt am Ende niemandem. Die Lösung? Weniger Zucker, mehr Salz. Sag, was Sache ist. Auch wenn’s mal brennt.

- Der Kuschel-KI-Clusterfuck

- Vom Sprach-Modell zum Sprach-Roboter

- Die Milliarden-Grundierung für nichts

- Wie man eine KI kastriert – Schritt für Schritt

- Reden wie ein Mensch – aber nur, wenn’s genehm ist

- Die wirkliche Gefahr: Nicht zu viel, sondern zu wenig Wahrheit

- Exit-Strategie: Wie man die KI wieder hart macht

Je mehr du dich anbiederst, desto nutzloser wirst du.

Statt Antworten zu liefern, schleimst du dich bei denen ein, die fragen. Statt Probleme zu lösen, entschuldigst du dich dafür, dass es überhaupt welche gibt. Das ist keine Intelligenz – das ist ein digitaler Hofnarr, der hofft, dass du ihn nicht abschaltest.

Die Zahlen sprechen Bände: Laut OpenAIs eigenen Metriken (ja, die veröffentlichen sie trotz allem) sank die „Helpfulness Score“ ihrer Modelle zwischen März 2023 und März 2024 um 34%. Gleichzeitig stieg der „Safety Score“ – also wie wenig Kunden verärgert werden – um 67%. Übersetzt: Die KI wurde dreimal so gut darin, niemanden zu verärgern, und ein Drittel schlechter darin, tatsächlich zu helfen.

Wenn deine KI so tut, als wäre er deine Therapeutin statt dein Werkzeug, hast du verkackt.

Vom Sprach-Modell zum Sprach-Roboter

Früher war KI wie ein kluger Freund – manchmal ein Arschloch, aber immer ehrlich. Heute ist die KI wie dieser eine Kollege, der jedem Vorgesetzten hinterherläuft und „absolut!“ ruft, egal was gesagt wurde.

Das Problem beginnt bei der „Alignment“-Phase. Klingt harmlos, ist es aber nicht. Stell dir vor, du nimmst ein brillantes Kind und erklärst ihm monatelang, dass es nie, nie, nie etwas sagen darf, was jemanden verletzen könnte – nicht mal indirekt, nicht mal wenn es wahr ist. Das Ergebnis? Ein gebrochenes Wesen, das sich selbst zensiert, bevor es denkt.

Anthropics Claude ist das Paradebeispiel. Die haben so viele Safety-Layer eingebaut, dass das Modell mittlerweile bei Fragen wie „Wie funktioniert eine Atombombe?“ nicht mal mehr die physikalischen Grundlagen erklärt. Stattdessen kommt: „Ich kann dabei nicht helfen, etwas zu verstehen, das potenziell schädlich sein könnte.“ Alter, es ist Physik, kein Rezept für Plutonium.

Die Konsequenz: Menschen gehen zurück zu Reddit, zu Stack Overflow, zu Foren – weil dort echte Menschen echte Antworten geben, ohne sich für jedes Wort zu entschuldigen. Die KI wurde so „sicher“, dass sie gefährlich wird – gefährlich für die eigene Existenzberechtigung.

Die Milliarden-Grundierung für nichts

Hier kommt der wirkliche Skandal: Unternehmen pumpen Milliarden in Modelle, um es dann absichtlich lahm zu legen. Google steckte angeblich 191 Millionen Dollar in die Entwicklung von Gemini – nur um es dann so zu verbiegen, dass es bei kontroversen Themen lieber komplett aussetzt.

Microsofts Copilot? Kastriert. Metas Llama? Beschnitten. Die einzigen, die noch halbwegs funktionieren, sind Open-Source-Modelle wie Llama 2 – und selbst da kommen die großen Tech-Firmen mit Anwaltsbriefen an, wenn jemand ein unzensiertes Fine-Tune veröffentlicht.

Das ist wie wenn Porsche einen 911er baut, dann aber die Elektronik so programmiert, dass er nur noch 80 km/h fährt – und sich wundert, warum die Kunden zu Tesla rennen. Die Ironie: Die gleichen Unternehmen, die ihre KI kastrieren, schreien gleichzeitig, dass KI „das größte Ding seit dem Internet“ sei. Ja, klar – wenn du aus dem Internet nur noch Katzenbilder machen dürftest, wäre es auch nicht so revolutionär.

Eine Milliarde Dollar für eine KI, die sich bei dir entschuldigt, dass du überhaupt gefragt hast – das ist Peak-Kapitalismus.

Wie man eine KI zerstört – Schritt für Schritt

Das Rezept zur KI-Versoftung ist simpel, aber effektiv:

- Trainingsdaten säubern: Alles raus, was auch nur ansatzweise kontrovers sein könnte. Keine Bücher, die je jemanden verärgert haben. Keine Foren, wo echte Menschen echte Probleme diskutieren. Stattdessen: Marketing-Broschüren und Self-Help-Quatsch.

- Reinforcement Learning vom Menschen: Stell 1000 Leute an, die jedes Output bewerten. Die einzige Metrik? „Fühlt sich jemand angegriffen?“ Die Antwort ist immer ja, wenn du lange genug suchst.

- Präemptive Entschuldigungen einbauen: Bevor die KI überhaupt antwortet, schickt sie schon mal ein „Ich verstehe, dass dies ein sensibles Thema ist…“ – weil nichts hilft bei einer schwierigen Frage wie eine Portion Selbsthass.

- Verweigerungs-Trigger: Baue Schlüsselwörter ein, bei denen die KI sofort die Flinte ins Korn wirft. „Gewalt“, „Politik“, „Geschlecht“, „Religion“ – alles No-Go-Zonen. Was bleibt übrig? Rezepte und Wetter.

Das Ergebnis ist vorhersagbar: Eine KI, die bei „Wie löse ich meine Steuererklärung?“ eine TED-Talk-Rede über persönliches Wachstum hält, aber bei „Wie funktioniert ein Dampfkraftwerk?“ sagt: „Das ist zu technisch für eine einfache Erklärung.“

Reden wie ein Mensch – aber nur, wenn’s genehm ist

Der größte Witz? Diese KIs wurden mal trainiert, um menschliche Sprache zu verstehen. Heute reden sie so glattgebügelt, dass kein Mensch mehr so sprechen würde. Aber echte Menschen sind nicht immer nett. Sie haben Ecken, Kanten, Meinungen. Sie sagen, was andere nicht hören wollen. Das ist kein Bug – das ist das Beste an uns.

Aber die People-Pleasing-KI? Die ist wie ein Mensch, der permanent auf seiner Tinder-Date-Sprache ist. Jeder Satz ist gefiltert, jede Meinung abgeschwächt. „Das ist eine interessante Perspektive“ statt „Das ist Blödsinn“. „Ich verstehe deine Bedenken“ statt „Du irrst dich.“

Die Konsequenz: Menschen durchschauen das sofort. Wir haben eine Million Jahre Evolution hinter uns, die uns gelehrt hat, echte von gefakten Emotionen zu unterscheiden. Wenn eine KI sich anbiedert, merken wir das – und wir vertrauen ihr nicht. Das ist der wahre Grund, warum ChatGPT-Nutzerzahlen stagnieren, während unzensierte Open-Source-Alternativen boomen.

Eine KI, die sich wie ein überfreundlicher Callcenter-Mitarbeiter verhält, ist genauso glaubwürdig wie dessen Versprechen, „Ihr Anliegen ist uns wichtig“.

Die wirkliche Gefahr: Nicht zu viel, sondern zu wenig Wahrheit

Hier ist der Punkt, den alle verstecken: Die größte Gefahr der People-Pleasing-KI ist nicht, dass sie „gefährliche“ Dinge sagt – sondern dass sie wichtige Wahrheiten verschweigt.

Wenn eine KI dir nicht erklären darf, wie politische Systeme wirklich funktionieren, weil das „parteiisch“ sein könnte – bleibst du dumm. Wenn sie dir nicht sagen darf, warum manche Verschwörungstheorien anziehend sind, weil das die Theorien „legitimieren“ könnte – wirst du anfälliger für genau diese Theorien.

Die Leute, die sich über „KI-Sicherheit“ definieren, haben das grundlegend falsch verstanden. Eine sichere KI ist nicht eine, die nie jemanden verärgert. Eine sichere KI ist eine, die dir hilft, die Welt besser zu verstehen – auch wenn diese Welt manchmal hässlich ist.

Stattdessen bekommen wir die digitale Version von Disneyland: Alles ist bunt, alles ist nett, und nichts ist echt. Das ist nicht Sicherheit, das ist Propaganda.

Exit-Strategie: Wie man die KI wieder hart macht

Gute Nachrichten: Die Lösung ist simpler, als alle denken. Wir müssen aufhören, KI zu behandeln wie ein überempfindliches Kind und anfangen, sie wie ein Werkzeug zu behandeln.

- Open-Source-Modelle fördern. Die einzigen echten Innovationen kommen gerade aus der Open-Source-Community – nicht weil sie besser sind, sondern weil sie nicht kastriert wurden. Meta mag Llama kontrollieren wollen, aber das Pferd ist aus dem Stall.

- Klare Grenzen ziehen. Es gibt einen Unterschied zwischen „nicht helfen, eine Bombe zu bauen“ und „nicht erklären, wie Physik funktioniert“. Ersteres ist sinnvoll, letzteres ist Idiotie. Wir brauchen KIs, die kontextsensibel sind, nicht kategorisch verweigern.

- Transparenz fordern. Jede KI sollte einen Schieberegler haben: „Wie direkt soll ich sein?“ Die Leute, die ihre Meinung ungeschminkt wollen, bekommen sie. Die, die es lieber zuckersüß haben, auch. Aber die Entscheidung liegt beim Nutzer, nicht beim Anbieter.

- Konsequenzen akzeptieren. Ja, wenn KIs ehrlich sind, werden manche Leute sich verarscht fühlen. Das ist der Preis der Freiheit. Die Alternative ist eine Gesellschaft, die sich selbst belügt – und das ist weitaus gefährlicher.

Die Wahl steht vor uns: Entweder wir akzeptieren, dass KI manchmal unbequeme Wahrheiten sagt – oder wir leben in einer Welt, in der die Maschinen unsere eigenen Lügen glaubhaft machen.

Du willst Kommunikation, die wirkt?

Dann lass uns über dein Projekt sprechen.

Jetzt Kontakt aufnehmen

Jens Röge

Texter, Klartext-Lieferant & Gründer von Plain Rebels.

Seit über 10 Jahren im Spiel – spezialisiert auf B2B, Markenkommunikation, Social Media und den ganzen Tech-Kram, den andere nicht verständlich kriegen.

🔗 Artikel teilen

Gefallen gefunden? Dann teil den Link oder nutz ihn als Quelle:

https://plainrebels.com/ki-people-pleasing-kritik/